Neuerdings besuche ich die Netzblicke, eine lose Vortragsreihe der IHK München. Hier sprechen Gastreferenten über Internet-Themen, die für Selbständige nützlich sein könnten. Im Oktober war das Thema Suchmaschinenoptimierung (SEO) dran – ein komplexes Thema mit halbseidenem Beigeschmack: Zu viele Agenturen und Glücksritter versuchen, Google auszutricksen, um mit ihren Seiten in den Suchergebnissen möglichst weit vorne gelistet zu sein. Das hat auch Folgen für andere.

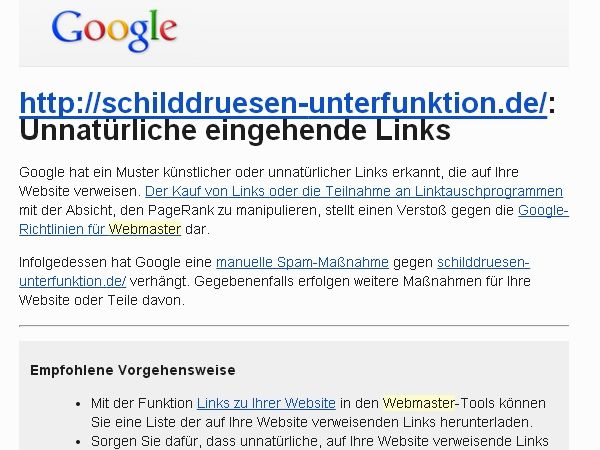

Screenshot: Benachrichtigung von Google über manuelle Spam-Maßnahme

Meine Website zur Schilddrüsenunterfunktion hatte im August die Quittung für solche Praktiken bekommen: Google hatte einen Rundumschlag gegen Webseiten gemacht, die verdächtigt wurden, Links zu anderen Webseiten zu kaufen oder zu verkaufen. Mich erreichte eine „manuelle Spam-Maßnahme“, also eine Abstrafung, obwohl ich mich gar nicht an solchen Tricks beteiligt hatte und meine Website in diesem Jahr sowieso nur selten irgendwo verlinkt hatte. Anscheinend genügte es, Links von einer Website zu bekommen, die zusätzliche bezahlte Links zu anderen Seiten gesetzt hatte.

Google geht gegen plumpe Manipulationen vor

Von einer derartigen Abstrafung erfährt man nur dann direkt, wenn die betreffende Website in Googles Webmasterzentrale angemeldet ist. Ansonsten kann man nur die verschlechterte Auffindbarkeit feststellen und spekulieren, woran es wohl liegen mag – an einer manuellen Maßnahme oder an einer allgemeinen Änderung im Algorithmus?

Nach einigen Anpassungen, die Google günstig stimmen sollten, reichte ich meine Website zur erneuten Überprüfung ein, der Antrag wurde genehmigt und die Besucherzahlen stiegen schon nach wenigen Tagen wieder auf das frühere Niveau an. Umso größer meine Skepsis gegenüber SEO: Viele Agenturen, die vor einem Jahr noch Geld dafür genommen hatten, eine Website an allen möglichen und unmöglichen Stellen zu verlinken, verdienen heute daran, diese Links wieder zu entfernen: Google lässt sich nicht mehr durch zahllose Links aus unpassenden Quellen beeindrucken.

Vorsicht – Links mit zweifelhafter Qualität

Deshalb war ich überrascht, dass die Netzblicke-Referenten vom September in ihren Vortrag über PR die Online-Presseportale ziemlich pauschal empfahlen – für die Pressearbeit und für ein besseres Ranking bei Google. Die Qualität der dort eingereichten Meldungen ist aber sprachlich wie inhaltlich sehr heterogen, und manche PR-Portale setzen nur noch solche Links, die nicht für den Pagerank zählen, um die Spammer abzuschrecken.

Doch bei den jüngsten Netzblicken mit Markus Groiß ging es gar nicht um die Frage, wie man geeignete Links zur eigenen Website abstaubt, sondern um Verbesserungen auf der eigenen Website – also um Onpage-Optimierung. Manches überschneidet sich mit Benutzerfreundlichkeit („Usability“), Google kann zum Beispiel erkennen, wenn eine Website viele Rechtschreibfehler enthält. Auch die Aktualität von Inhalten in jeder Form („Freshness“) ist wichtig: Dokumente zum Download sollten aktuell sein, die Ansprechpartner sollten stimmen. Die Ladezeit der Website hat ebenfalls Einfluss auf das Ranking bei Google.

Suchmaschinengerechte Inhalte anbieten

Seitentitel und Description sollte gut gewählt sein. Die Beschreibung ist zwar nicht relevant für das Ranking, kann aber einen Einfluss darauf haben, ob die Website bei Google tatsächlich angeklickt wird. Auch die Keywords sollten auf die einzelne Seite des Portals abgestimmt werden, anstatt auf allen Seiten dieselbe Keywordliste einzutragen. Bei WordPress lässt sich das gut machen, ich nutze dafür das Plugin „All in One SEO Pack“.

Der Webtext sollte ganz oder großteils „unique“ sein, also möglichst nicht an anderer Stelle im Netz auftauchen. Das gilt aber auch für Fotos – eigene Bilder sind besser als Stockfotos, also eingekaufte Massenware. Für Fotos empfahl der Referent das Seitenformat 4:3, das bei vielen Digitalkameras ohnehin üblich ist. Bilder sollten mit passendem Dateinamen und Alt-Text versehen werden, und sogar der Ordnername des Fotos kann ein Rankingfaktor sein. Hier hat man bei WordPress zwar kaum Spielraum, aber dafür hat man ja die sprechenden URLs, die der Referent nicht erwähnte.

Google entwickelt sich ständig weiter

Ein Trend bei Google selbst ist, dass die Spezialsuchen – Web, Bilder, Videos, News, Maps – unwichtiger werden und Google diese Funktionen zusammenführt, erklärte der Referent. Die Tendenz geht dahin, dass Google anhand der Suchbegriffe selbst erkennt, welche Art von Suchergebnissen gerade gefragt sind. Die Besucher sind immer weniger bereit, auf die zweite Seite zu klicken, während den ersten Treffern viel Vertrauen entgegen gebracht wird. So kann man nur hoffen, dass die echten Spammer nach hinten verbannt werden.

Stand: 20.10.2014

Halle Irene,

netter Ausflug in die Welt der SEO, mit einer teilweise falschen Information. Richtig ist das ein, optional zwei Keywords auf die einzelne Seite abgestimmt werden sollten. Keywordlisten zu benutzen macht im Grundsatz schon keinen Sinn, weil ein Beitrag zum Thema x auch auf das Keyword x ausgerichtet wird. Im normalen Schreibfluss ergeben sich somit Longtail-Keywords zu Keyword x, Google erkennt das und wertet es ebenso positiv.

Die Keyworddichte sollte ein bis zwei Prozent betragen, was bei einer Keywordliste schon mit nur fünf Keywords den Beitrag künstlich in die Länge zieht. Google erkennt das und bewertet den Text als weniger infomativ. Folglich landet man wieder weiter hinten in den SERPs.

Hat der Referent seine Aussage bezüglich des 4:3 Formats von Bildern irgendwie belegt, mir fehlt dazu eine schlüssige Begründung, weshalb das besser sein sollte.

Beste Güße

Keywordlisten zu benutzen macht im Grundsatz schon keinen Sinn, weil ein Beitrag zum Thema x auch auf das Keyword x ausgerichtet wird.

Der Referent arbeitet für eine Agentur und diese wiederum für große Kunden. Demnach kommt es bei manchen Firmen tatsächlich vor, dass eine eine Keywordliste erstellt wurde und diese bei sämtlichen Unterseiten identisch eingetragen. Die Botschaft des Referenten war einfach, dass die Keywords für jede Unterseite individuell festgelegt werden sollten.

Bei Blogs und manch anderen Content-Management-Systemen mit einem Zusatzformular für Keywords ergibt sich das ja fast von selbst – man trägt ja die Keywords jedesmal zusammen mit dem Text ein. Um die Keyworddichte ging es dabei gar nicht. Es ging auch nicht nur um Text, weil viele Firmen viel anderen Content haben, z. B. Datenblätter.

Hat der Referent seine Aussage bezüglich des 4:3 Formats von Bildern irgendwie belegt, mir fehlt dazu eine schlüssige Begründung, weshalb das besser sein sollte.

Leider nein, er erwähnte irgendwie die Formate der Displays, aber das wäre dann ein reines Usability-Argument und nichts fürs Ranking. Vielleicht werden noch die Folien bei Netzblicke hochgeladen, vom September-Vortrag über Online-PR gibt es das.)

Habe jetzt folgende Formulierung im Blogeintrag ergänzt:

Auch die Keywords sollten auf die einzelne Seite des Portals abgestimmt werden, anstatt auf allen Seiten dieselbe Keywordliste einzutragen.

Hallo Irene,

die besten Suchergebnisse auf der ersten Seite ist auch heute noch nicht wirklich gegeben. Ich selber finde viele Themen bei der Google-Suche erst auf Seite zwei oder drei. Auf der ersten Seite ist leider häufig immer noch sehr viel „Müll“ zu finden. Ich bemerke aber, dass Google hier in die richtige Richtung geht und die Suche nach und nach besser wird.